根据Epoch AI发布的最新行业研究报告,全球科技巨头正在主导一场历史上规模最大的基础设施扩建浪潮。这场以AI数据中心为核心的建设,其电力需求、资本投入及技术密度正以前所未有的速度重塑能源与基建格局。

作为衡量AI数据中心规模的核心指标,电力供应已成为选址的决定性因素。研究数据显示,到2027年底,仅美国境内的AI数据中心总电力需求预计将达到20至30吉瓦(GW)。这一数字约占美国当前平均总发电量的5%,在部分电力网络较小的国家,如英国或日本,同等规模的需求占比将分别高达90%和25%。

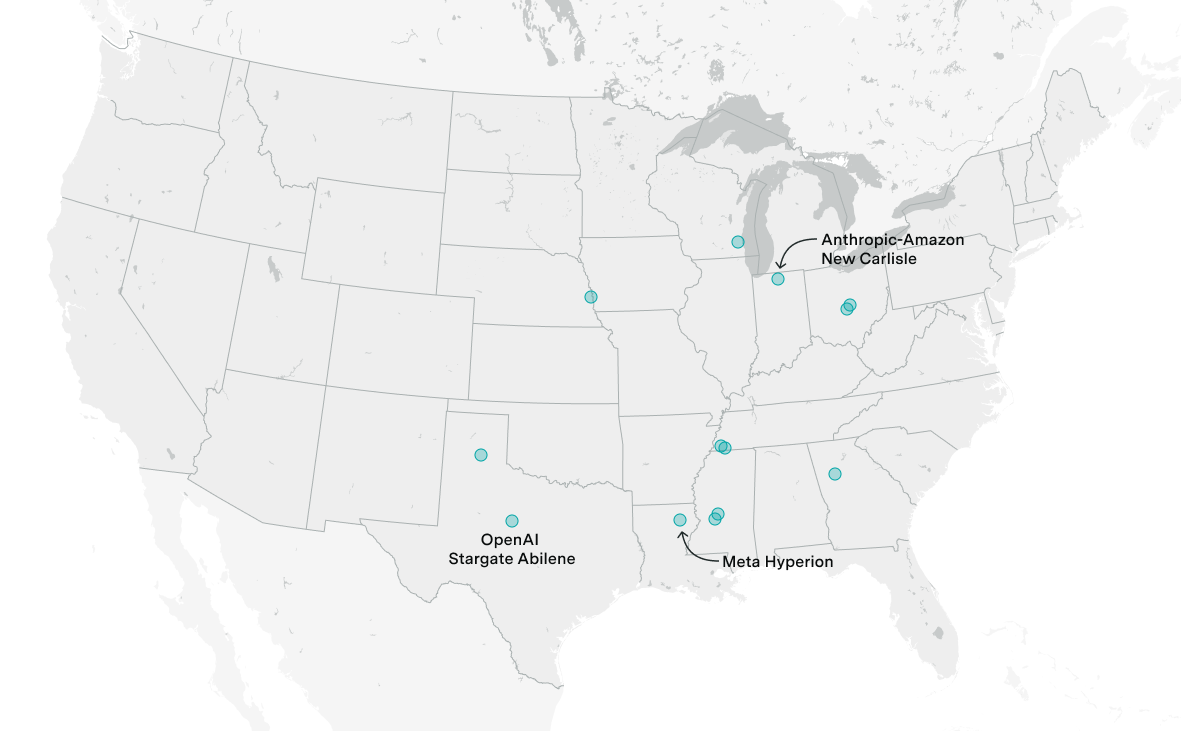

以OpenAI的Stargate Abilene项目为例,该数据中心的电力需求约1吉瓦,足以供应西雅图整个城市的用电。其算力规模预计将超过训练GPT-4所用超级计算机的250倍。这种极端化的电力需求促使开发商将目光投向得克萨斯州等能源丰富且监管压力较小的地区,初期主要依靠现场天然气发电,随后逐步接入电网。

从金融分析的角度看,AI基础设施的资本开支已接近阿波罗计划和曼哈顿计划。Stargate项目的单体建设及IT设备成本高达320亿美元。到2027年,全球AI数据中心的累计投资额预计将达到数千亿美元。高昂的成本主要源于IT设备的高集成度,例如英伟达NVL72机架的功率密度超过每机架100千瓦,是普通数据中心的10倍。

极高的功率密度对散热技术提出了严苛要求,液冷系统已成为行业标配。相比传统风冷,液冷板与循环水系统的热交换效率更高。虽然这引发了对水资源利用的关注,但数据分析显示,2023年美国数据中心直接用水量约为174亿加仑,仅为农业用水量(约36.5万亿加仑)的极小部分,短期内尚未构成宏观气候风险。

行业趋势显示,虽然分布式训练在缓解电力压力方面具备潜力,但在未来两年内,集中式训练仍将是主流。这主要由于单个大型数据中心(如预计功率达3.3吉瓦的Microsoft Fairwater)能够提供更高效的网络通信环境。当前的扩张速度表明,算力增长尚未触及物理天花板,但能源获取的周期将成为制约 frontier model 演进的主要瓶颈。

洞察未来,AI数据中心正从单纯的IT设施演变为能源系统的核心负载点。随着单体项目向吉瓦级迈进,能源供应的安全性与绿色化将成为企业竞争的核心壁垒。长期来看,数据中心对天然气的依赖将向核能及储能配套转变,这种转型不仅决定了AI主权的归属,也将倒逼全球电网进行半个世纪以来最大规模的架构升级。

文章来源:Epoch AI

注:本文由 AI 生成,内容仅供参考,不代表本站态度或观点,请谨慎鉴别!

更多阅读: