本文是纽约大学助理教授 Sam Bowman 关于自然语言处理中深度学习活跃领域的课程讲义PPT。对深度学习NLP领域最近较为活跃的研究进行了综述,其中包括Attention 模型、结构化记忆、词水平以上的无监督学习等等。Sam Bowman 在斯坦福大学完成博士学位,是Kris Manning 和 Chris Potts的学生。

我们正在快速进步

深度学习中的活跃研究领域之NLP。

大多数6岁儿童都能处理的语言问题,现在机器还远远做不到……但是,我们正在快速进步中。

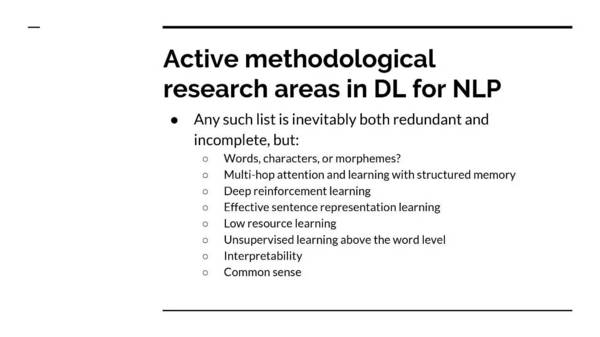

目录:

词,字或词素?

Muti-hop 注意力和结构化记忆学习

深度增强学习

有效的句子表征学习

低资源学习

在词水平线上的无监督学习

可解释性

常识

词,字和词素的优势和劣势

词,字或词素

问题:我们如何把文本跨度表示为一个神经网络模型的输入或者输出?

换句话说:

编码器应该看到什么类型的符号?

解码器应该产生什么类型的符号?

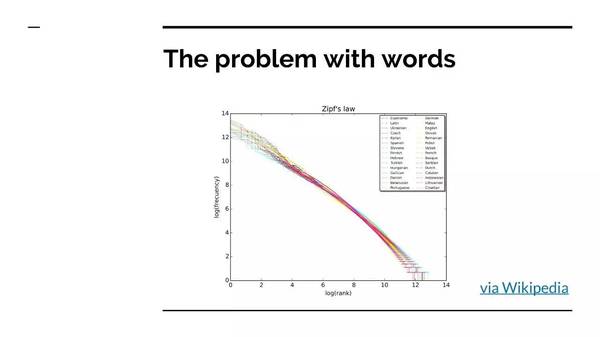

词语本身的问题?

优势:

容易标记化

与意义单元的基础相近

劣势:

词汇组成很大

词素?

优势:意义的基本单元

劣势:很难标记化

词汇组成依然很大

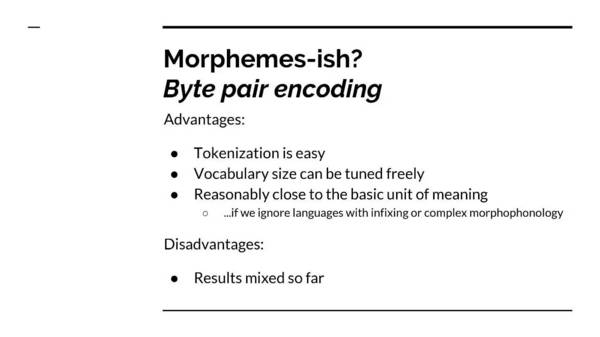

字节配对编码

优势

标注化比较简单

词汇构成可以自由条换

与意义的基本单元比较接近

劣势:

目前结果很混乱

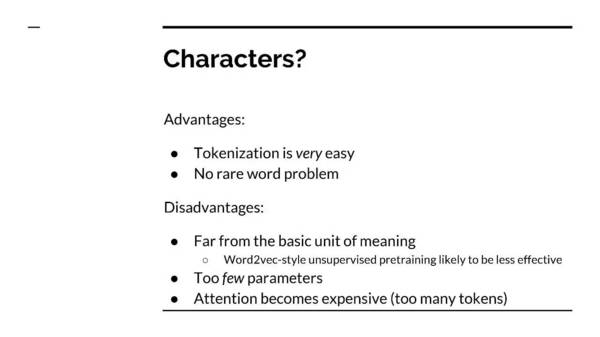

字(字母)?

优势:

非常便于标注

没有生僻词的问题

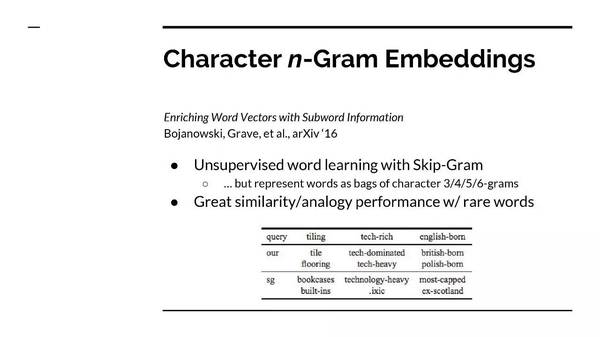

最近的研究

1.字母 n-Gram 嵌入

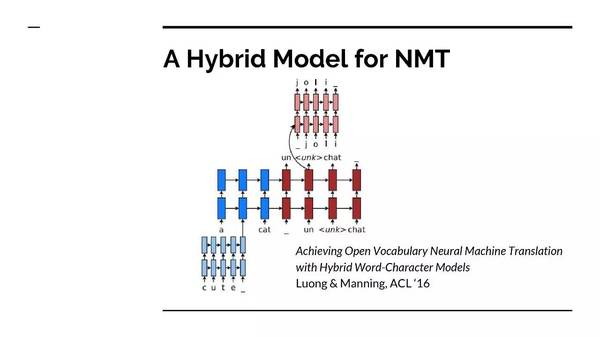

2. 神经机器翻译的一个混合模型

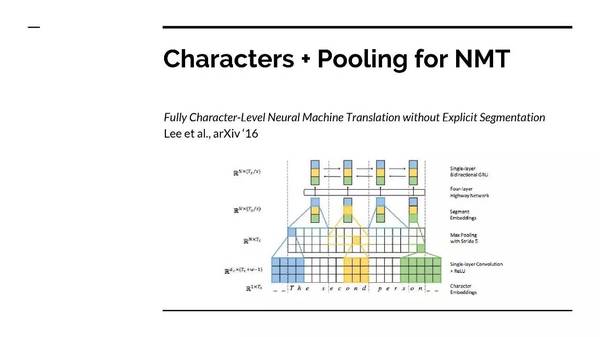

3. 神经机器翻译的字母+池化

Multi-HOP Attention 和 结构化记忆

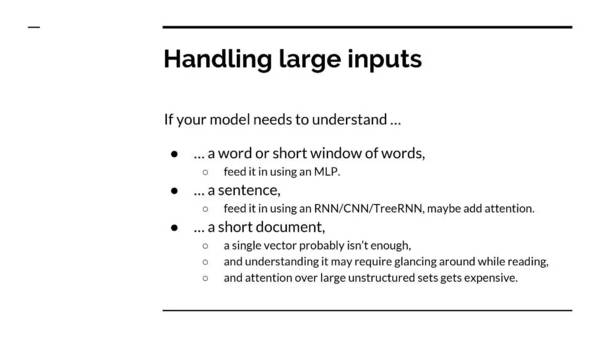

处理大型的输入

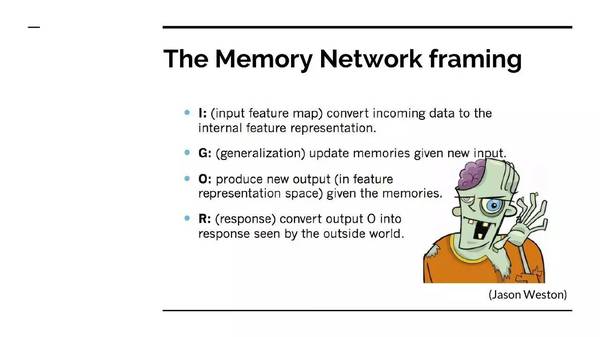

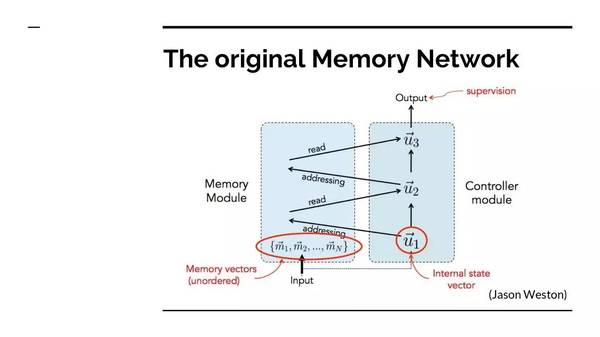

记忆网络框架

原始记忆网络

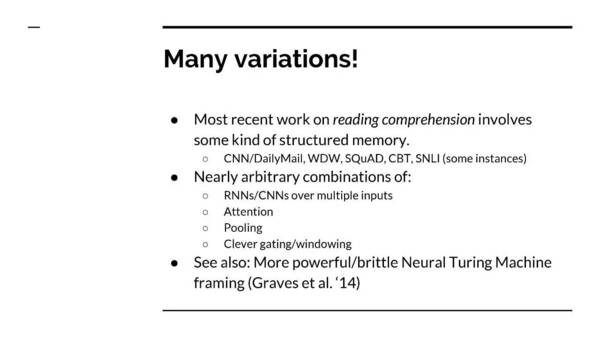

多变量:最近的研究,大多数都是关于阅读理解,包含了一些结构化的记忆。

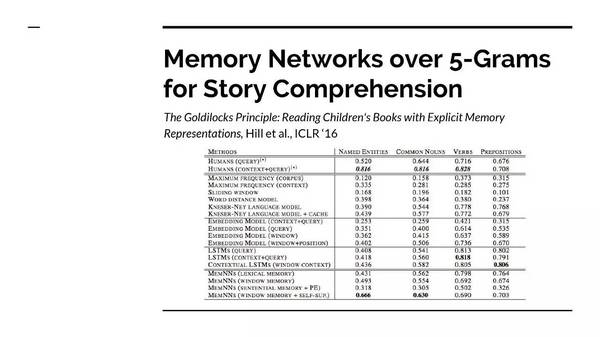

故事理解中,超过5-Grams的记忆网络

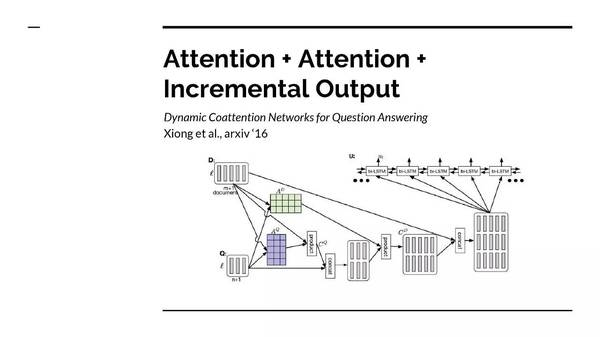

Attention + Attention +增加输入

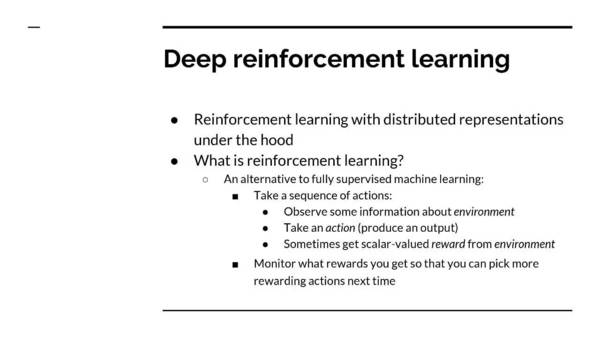

深度增强学习

深度增强学习的定义和介绍

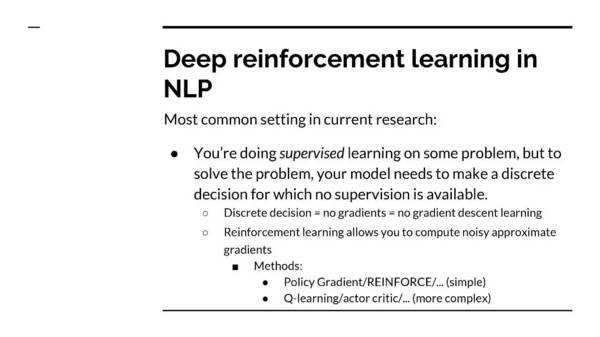

NLP 中的深度增强学习

一个例子:问答

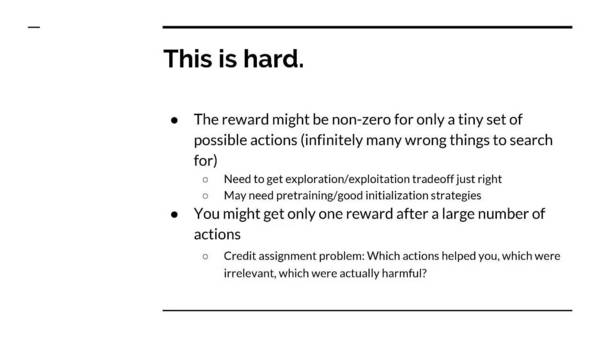

问答其实是很难的,回报可能是非零(Non-zero),只有一小部分可能的行动;在一大串的动作之后,你可能只得到一个回报。

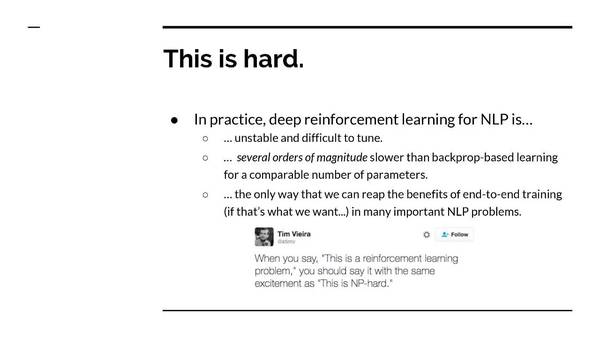

实际上,深度增强学习用于NLP是很难的

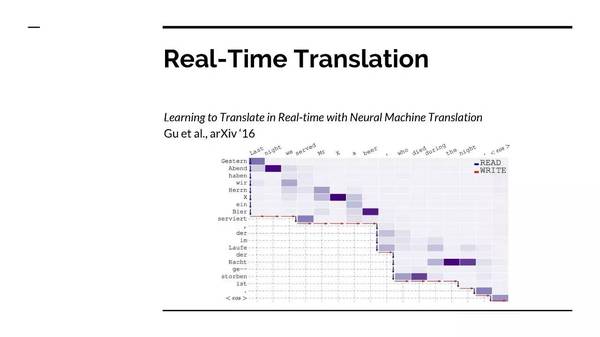

实时翻译

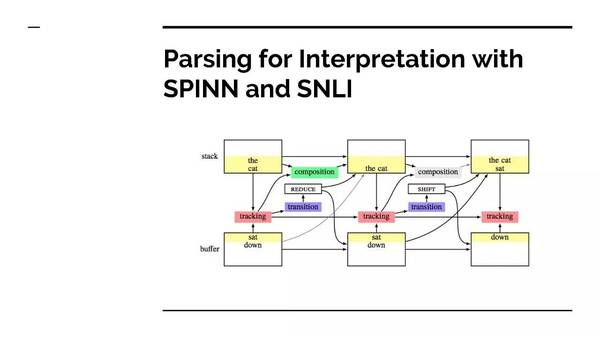

用于解释的语法分析,使用SPINN和SNLI

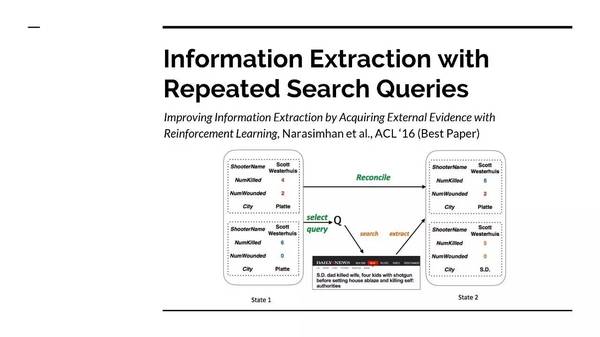

用重复的搜索命令进行信息提取

其他议题

低资源学习

可解释性

常识,常识推理

能从语言学中学到什么

最后提醒:本研究中提到的所有神经元指的都是一种有用的工具,任何与真实的神经元形成的类比,都纯属巧合。

摘自:新智元

更多阅读: