运用逻辑推理能力进行全面的自然语言理解尝试。随着生成预训练Transformer 4(GPT-4)的发布,它在推理任务上被称为“先进”的,我们渴望了解GPT-4在各种逻辑推理任务上的表现。本报告分析了多个逻辑推理数据集,包括流行的基准数据集如LogiQA和ReClor,以及新发布的数据集如ARLSAT。我们使用需要逻辑推理的基准测试多选阅读理解和自然语言推理任务。我们进一步构建了一个逻辑推理的分布外数据集,以调研ChatGPT和GPT-4的鲁棒性。我们还对ChatGPT和GPT-4的性能进行了比较。实验结果表明,在大多数逻辑推理基准测试中,ChatGPT的表现明显优于RoBERTa微调方法。在我们的手动测试中,GPT-4表现得更好。在这些基准测试中,ChatGPT和GPT-4在知名数据集如LogiQA和ReClor上表现相对较好。然而,在处理新发布和分布外的数据集时,性能显著下降。对于ChatGPT和GPT-4来说,逻辑推理仍然具有挑战性,尤其是在分布外自然语言推理数据集上。

https://www.zhuanzhi.ai/paper/60bedf74f62332e5c82c7a1bd40f0cf5

1. 引言

逻辑推理对人类智能至关重要,将逻辑推理能力纳入自然语言理解(NLU)系统自人工智能开始以来一直是一个活跃的研究兴趣(Cresswell, 1973) (Kowalski, 1979) (Iwanska´,1993)。研究人员一直在探索实现这一目标的各种方法,包括基于规则的方法、符号系统(MacCartney和Manning, 2007a)、微调大型语言模型(Wang等人,2018),以及结合神经和符号方法(Li和Srikumar, 2019)。

在传统的逻辑和语义方法中,计算语言学家开发了利用一阶逻辑(FOL)或自然逻辑(macaccartney和Manning, 2007a)的符号系统来解决基本的推理任务。基于规则的模型很难用手工制定的规则和定理证明器来解决诸如RTE挑战(Dagan等人,2005年)等问题。早期研究人员采用的形式逻辑推理提出了符号系统和手工设计的规则,其中知识使用形式逻辑或其他符号表示显式地表示。通过规则,系统可以进行演绎操作。然而,这些方法在处理模糊性和可扩展性方面面临挑战。它们在处理真实世界的自然语言数据时很脆弱。

神经网络模型时代看到了大规模NLI数据集的兴起作为流行基准。例如,SNLI (Bowman等人,2015)和多流派NLI (MNLI) (Williams等人,2018)数据集是通过众包创建的,具有巨大的数据规模和广泛的覆盖面。它们促进了具有更好表示能力的模型的发展,并成为自然语言理解研究的首选基准。随着基于transformer (Vaswani et al., 2017)的语言模型(如BERT (Devlin et al., 2018)的出现,模型性能的巨大飞跃,这些模型的训练方案使它们能够访问巨大的未标记语料库。因此,构建具有数万亿参数的语言模型成为可能(Brown et al., 2020) (Raffel et al., 2019)。预训练和微调的范式自此成为文本推理任务的主要解决方案。研究人员在对大规模文本语料库进行预训练后,对特定任务数据集的语言模型进行微调。大型预训练语言模型(LMs)在流行的NLI和MRC基准上取得了超越人类的表现,这促使人们在文本推理方面进行更复杂的基准测试。

随着最近几个数据集的发布,逻辑推理NLP研究重新获得了势头,特别是LogiQA和Reclor。数据集来自中国公务员考试和法学院入学考试(LSAT)等逻辑推理考试。这些测试即使对人类来说也是具有挑战性的,并且是高质量的Golden标记数据。逻辑推理被用于大型预训练语言模型(PLM)的许多探测任务和问答和对话系统等下游任务中。与传统基准相比,PLM表现不佳。尽管到目前为止取得了进展,但在NLU系统中实现类似人类的逻辑推理能力仍然是一项具有挑战性的任务。生成式预训练Transformer 4 (GPT-4) (OpenAI, 2023)以及ChatGPT是OpenAI新发布的语言模型,旨在理解和生成多模态内容。GPT-4在需要逻辑推理的任务中具有更强大的能力。逻辑推理对人类的智能至关重要,它使我们能够根据给定的信息得出结论、做出预测并解决问题。将逻辑推理纳入到语言模型中,如GPT-4,可以彻底改变自然语言理解(NLU)系统,使其更准确,更鲁棒,并能够理解自然语言中的复杂信息。

对ChatGPT和GPT-4在逻辑推理任务上的性能进行了评估,探索了它们在多个逻辑推理基准上的性能,详细分析了ChatGPT和GPT-4在逻辑推理任务上的优势和局限性。我们将讨论评估GPT-4逻辑推理能力的两个任务:多项选择阅读理解和自然语言推理。这两个任务都是推理繁重的,并可作为测试模型推理能力的游乐场。在这两种任务下,已经发布了多个逻辑推理数据集。事实证明,这些基准对于PLM来说很难解决。希望该报告能进一步揭示ChatGPT和GPT-4的逻辑推理能力。我们的贡献如下:

1. 在两个逻辑推理任务上测试了ChatGPT和GPT-4:多项选择阅读理解和自然语言推理。在多个逻辑推理测试集上进行实验,分析ChatGPT和GPT-4的逻辑推理能力。

2. 该文构建了一个分布外逻辑推理数据集,进一步研究了ChatGPT和GPT-4的鲁棒性。

3. 实验表明,ChatGPT和GPT-4都擅长解决著名的逻辑推理阅读理解基准,但在处理分布外数据集方面很困难。它们在需要逻辑推理的自然语言推理任务上的性能仍有待提高。

2. 实验设置

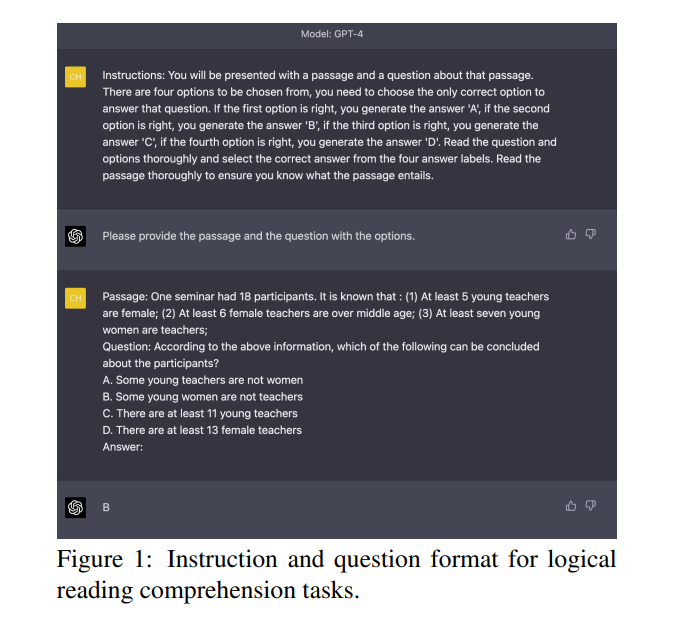

考虑多项选择阅读理解和自然语言推理任务进行评估。多项选择阅读理解在大型语言模型上进行了大量测试,因为这些任务通常具有结构清晰和高质量的数据集。另一方面,自然语言推理任务是评估推理能力的基本任务。

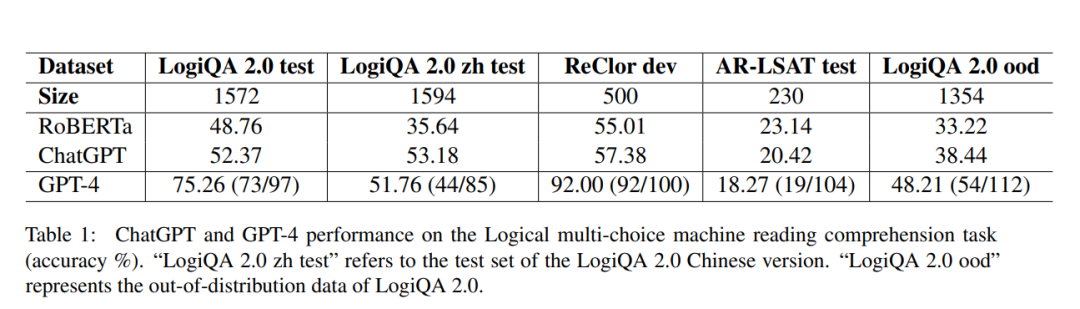

表1显示了多项选择阅读理解数据集的结果。ChatGPT显示,在几个长期基准上,与基线模型相比,性能有所提高。在LogiQA 2.0测试集上准确率达到53.37%,比RoBERTa基础模型高出近4个点。在中文LogiQA 2.0版本上进行测试时,ChatGPT与RoBERTa的性能差距较大,表明ChatGPT在中、英文语言上的性能具有一致性。ChatGPT在ReClor数据集上取得了57.38%的准确率,而RoBERTa的准确率为55.01%。然而,ChatGPT在分布外的数据集上的性能会大幅下降。在AR-LSAT测试集上,准确率仅为20.42%,低于RoBERTa base的性能。在LogiQA 2.0 ood上的性能为38.44%,仍然低于RoBERTa base。实验结果表明,ChatGPT在LogiQA和ReClor等逻辑推理系统中表现良好。ChatGPT的准确性略高于微调方法。然而,在新发布的AR-LSAT数据集和LogiQA 2.0分布外数据集上进行测试时,性能明显下降。

尽管有局限性,ChatGPT仍然代表了自然语言理解的重大进步,并展示了语言模型进行逻辑推理的潜力。在LogiQA和ReClor上进行手动测试时,GPT-4的性能明显优于ChatGPT。在LogiQA 2.0测试集上,GPT-4的准确率为75.26%。然而,在中文LogiQA 2.0测试集上,GPT-4在中文版本数据集上的准确率下降明显,达到了51.76%。在ReClor开发集上(ReClor在其测试中也不包括黄金标签),GPT-4达到了92.00%的准确率,这是显著的。然而,当在AR-LSAT测试集上进行测试时,GPT-4的表现令人惊讶地更差,只有18.27%的准确率。在LogiQA 2.0 ood数据集上的测试结果表明,GPT-4的正确率仅为48.21%,明显低于在ReClor数据集上的正确率。我们不会急于得出结论,但可以肯定地说,GPT-4在分布外数据集上的性能下降是明显的。

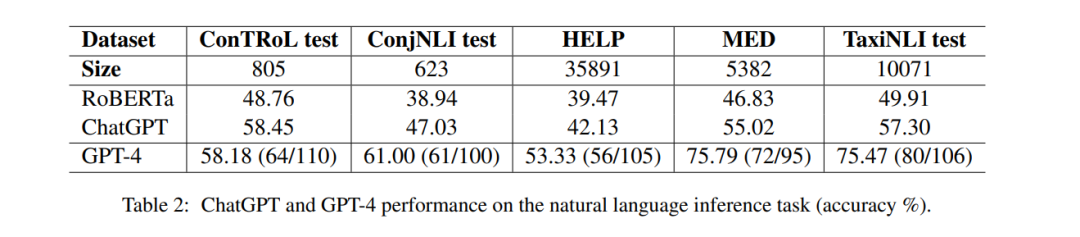

在自然语言推理任务上的实验结果表2展示了在自然语言推理数据集上的结果。在逻辑推理NLI数据集上,ChatGPT的性能优于RoBERTa模型。在对照测试集(805个实例)上,准确率达到58.45%,比RoBERTa-base模型高出近10%。在ConjNLI测试集(623个实例)上,ChatGPT的准确率为47.03%,比RoBERTa高出约9%。在HELP数据集(35891个实例)上,ChatGPT获得了42.31%的准确率,比RoBERTa高出约3个点。在MED数据集(5382个实例)上,ChatGPT的准确率为55.02%,比RoBERTa高出近9%。在TaxiNLI测试集(10071个实例)上,ChatGPT取得了57.30%的准确率,比RoBERTa算法提高了7%以上。由于我们注意到ChatGPT不擅长遵循NLI任务指令,因此我们提供了一个上下文示例来帮助模型生成任务标签,如图2所示。总的来说,结果表明,与在阅读理解任务上的表现相比,ChatGPT仅以很小的优势超过微调后的RoBERTa。

我们在五个NLI数据集上测试了GPT-4的性能。一般来说,GPT-4的性能比ChatGPT好,但结果并不令人惊讶。在对照测试集上,GPT-4的表现与ChatGPT相当,获得了58.18%的准确率。在ConjNLI测试集和HELP上的准确率分别为61.00%和53.33%,表现略好。在MED和TaxiNLI数据集上的性能较好,分别达到了75.79%和75.47%。在5个NLI数据集上的实验结果表明,与多项选择阅读理解相比,GPT-4在逻辑推理和自然语言推理上并没有表现出令人印象深刻的性能。在自然语言推理任务场景中,即使提供了指令,GPT-4也不能稳定地输出标签。由此我们可以推断,虽然GPT-4在多项选择阅读理解任务中训练得很好,但在自然语言推理任务中却不擅长遵循指令。

实验结果表明,ChatGPT和GPT-4在大多数逻辑推理基准测试上优于RoBERTa,包括流行的LogiQA和ReClor以及不太知名的AR-LSAT数据集。然而,对于两个GPT模型来说,分布外数据集的性能下降是明显的,这表明它们很难处理新的和不熟悉的数据。

更多阅读: