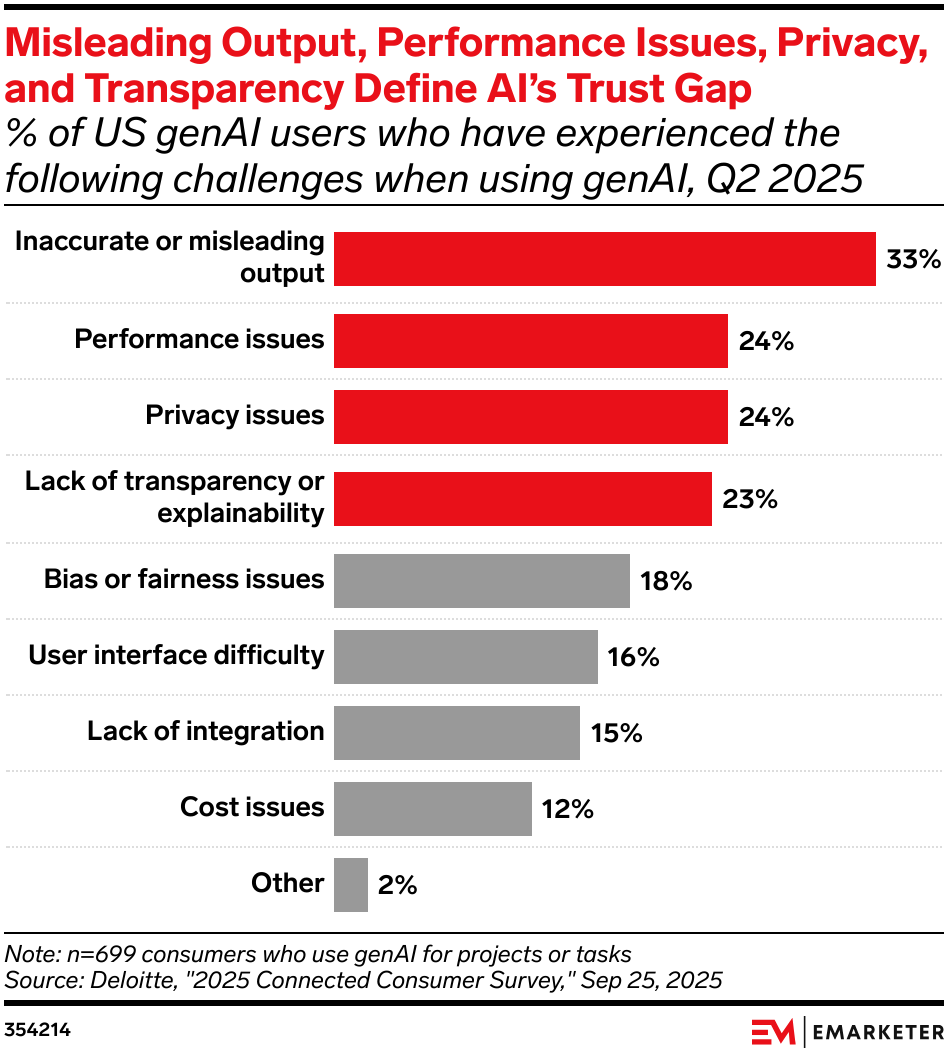

进入2025年第二季度,生成式AI虽然在应用广度上持续渗透,但在深度落地上正遭遇显著的信任瓶颈。Deloitte最新调研数据显示,在699名使用生成式AI处理任务的美国消费者中,信任鸿沟已然形成。其中,输出结果的不准确或误导性信息成为首要痛点,影响了高达33%的用户。这一数据直指大模型的核心软肋,表明尽管技术迭代迅速,但幻觉问题仍是阻碍技术从尝鲜走向生产力的关键壁垒。

除了准确性存疑,性能表现、隐私安全与透明度缺失共同构成了信任危机的第二梯队。数据显示,24%的用户遭遇了性能瓶颈,另有24%的用户对隐私泄露表示深度担忧。紧随其后的是缺乏透明度或可解释性,占比达23%。这四项核心挑战均超过了20%的阈值,且远高于偏见(18%)或用户界面困难(16%)等操作层面的问题,揭示了当前市场的核心矛盾已从易用性转向了可靠性。

值得关注的是,成本问题仅被12%的用户列为挑战,整合缺失占比为15%。这一分布特征极具金融分析价值,它反映出市场对AI价值的支付意愿相对较高,且基础生态已初具规模。然而,当准确性与隐私安全成为主要矛盾时,单纯的技术堆栈升级已不足以安抚市场。对于科技巨头而言,未来的竞争高地将不再仅是算力规模的军备竞赛,而是建立可信AI框架,解决黑箱机制带来的不确定性风险。

展望未来,AI治理将成为决定行业天花板的核心议题。随着三分之一的用户受困于误导性输出,单纯追求模型参数的边际效应将递减。行业趋势将向着高精准、可解释的垂直模型演进。只有当隐私保护与算法透明度不仅停留在合规层面,而是内化为产品的核心竞争力时,生成式AI才能真正跨越信任鸿沟,实现商业价值的长期复利。

Source: Deloitte

本文部分内容由 AI 生成,准确性和完整性无法保证,不代表本站的态度或观点

更多阅读: